简介

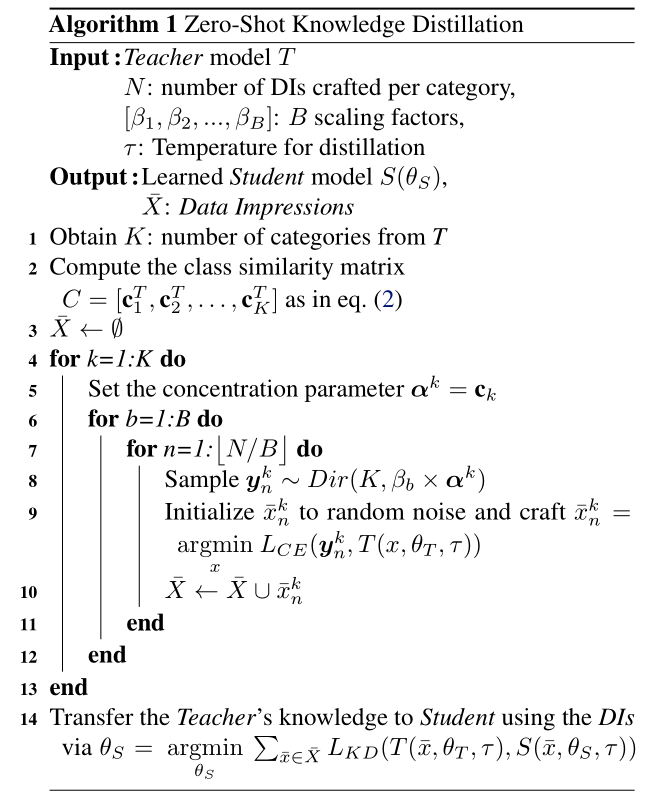

使用一种无数据的方法根据teacher网络来训练student网络。

即不使用元数据,而是从复杂的teacher模型中合成 data impression,并将其作为原始训练数据样本的替代,通过知识蒸馏的方式,将teacher模型特征转移到student上。

起因

- 知识蒸馏技术使用原始数据集进行训练效果会比较好

- 由于隐私和私密性问题,许多数据集是非公开的

优势

- 与现有的使用样本或元数据方法不同,本文首次提出零知识蒸馏想法,该方法没有数据样本,也没有提取的先验信息。

- 为了构成用于执行蒸馏的传递集,将softmax空间建模为Dirichlet分布,并根据teacher模型参数构建Data Impression(DI),提出一种样本提取机制。

- 根据类相似性提取有用的先验信息,从而更好的对数据分布进行建模,并在基于Dirichlet分布的DI生成框架中进行使用。

方法

生成DI

利用teacher模型的参数从其训练数据中合成伪样本

途径:对teacher的softmax输出进行建模